8 предрассудков о технологии дедупликации

28.02.2017

Технология дедупликации уже давно известна и применяется на практике не первый год. Но только использование современных массивов позволило в полной мере раскрыть весь потенциал этой технологии. Все современные массивы хранения данных используют инструменты дупликации для более эффективного использования места в хранилище для распределения архивных данных. Но не следует надеяться на то, что применение такой технологии имеет безграничные возможности и в любой массив можно определить безграничный объем архивируемой информацией.

Коэффициент сокращения данных: неограниченных возможностей не существует.

Технология дедупликации на сегодняшний день доступна для разных массивов, которые хранят как продуктивные данные, так и резервные копии информации. Показатель дедупликации для таких массивов может быть совершенно иным. Это означает что показатель, который достигнут в резервных массивах не может быть достигнут в продуктивном хранилище.

Поэтому, формируя конфигурации для хранения информации, а также для решения задач оперативного хранения данных следует тщательно подбирать оборудование, учитывая, что для разных задач показатель сжатия данных будет разным.

Чтобы исключить ошибки, возможные при использовании этой технологии, рассмотрим 8 мифов, которые обычно вводят в заблуждение многих пользователей и администраторов систем хранения данных.

Далее рассмотрим основные предрассудки, связанные с дедупликацией.

Большой показатель дедупликации обеспечивает больше преимуществ для хранения информации

Существует мнение, что если один из вендоров предлагает оборудование с коэффициентом дедупликации 50:1, то это лучше другого предложения с показателем 10:1. Верно ли такое утверждение? Для того чтобы определиться с ответом на этот вопрос нужно сравнить совокупную стоимость владения используемого оборудования.

Процедура дедупликации обеспечивает сокращение требования к ресурсам, но какую потенциальную экономию объема она способна обеспечить? При показателе 10:1 можно уменьшить размер хранимой информации на 90%. Если использовать конфигурации с показателем 50:1, то увеличиваются требования к ресурсам на 8% и обеспечивается 98% экономии объем. В результате получается только 8% разницы между двумя конфигурациями, которые на первый взгляд сильно отличались. В таком случае можно сделать выводы, что чем выше показатель дедупликации, тем меньше преимуществ по уменьшению объема информации можно получить. Такое утверждение выходит из закона убывающей доходности.

Существует четкое определение термина дедупликация

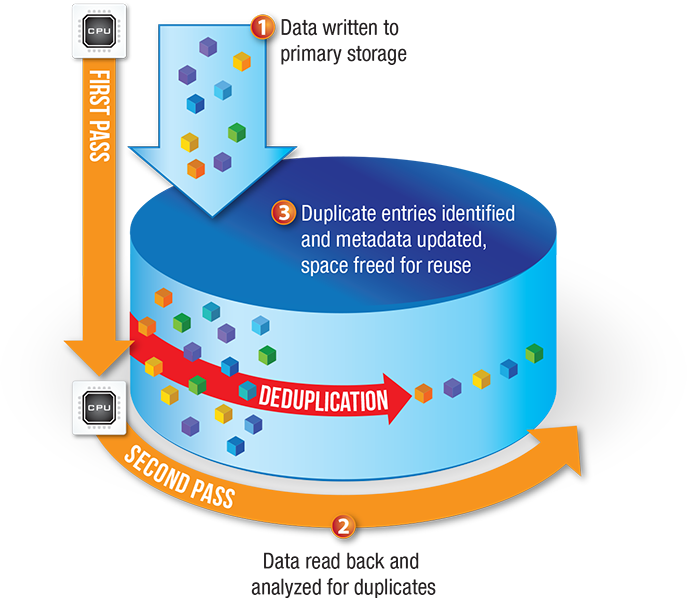

Технология дедупликации обеспечивает возможность сокращения объема хранимой информации посредством удаления повторяющихся данных из единого пула. Дедупликацию можно реализовать на файловом и блочном уровне либо же на уровнях контента и приложений. Большое число предлагаемых пользователю приложений вместе с дедупликацией сочетают и компрессию, что позволяет еще больше сократить объем хранимых данных. К сожалению, на сегодняшний день не существует единого определения, что именно представляет собой технология дедупликации и какие алгоритмы уменьшения объема информации подходят под этот информационный инструмент. В то же время для конечного пользователя важно, каким именно способом он сможет сэкономить имеющиеся дисковые ресурсы для хранения информации.

Рассмотрим какие варианты сокращения данных в массивах могут использоваться конечными пользователями на примере массива от HP 3PAR. Для работы с этими массивами разработан специальный комплекс HPE 3PAR Thin Technologies, который включает в свой состав 4 механизма.

- Thin Provisioning – этот механизм основан на использовании виртуализации дискового пространства, что позволяет, при освобождении ресурсов массива, не выполнять ревизию, а освободившееся блоки сразу применять для наполнения новой информацией.

- Thin Conversion – благодаря этому механизму можно переводить в реальном времени тома со старых массивов информации в новые с последующим сокращением объема томов на целевом устройстве

- Thin Persistence и Thin Copy Reclamation – с помощью этих ресурсов массив на гранулярном уровне понимает функционирование известных файловых систем и гипервизоров при удалении файлов. В таком случае освобождающиеся блоки переводятся в пул свободных ресурсов, которые доступны к последующему использованию.

- Thin Deduplication – такая методика позволяет применять технологию дедупликации в продуктивных массивах в режиме реального времени, исключая снижение общей производительности хранилищ.

Коэффициент дедупликации для основного массива такой же как и для массива с резервными данными

Разработчиками систем хранения информации практикуется применение различных алгоритмов дедупликации. Некоторые из таких алгоритмов нуждаются в больших ресурсах центрального процессора, чем остальные. Следовательно, показатель дедупликации может варьироваться в достаточно большом интервале значений.

Но, максимально влияет на то, какой показатель дедупликации будет для конкретного массива, количество повторяющихся данных. Поэтому системы резервного архивирования, которые могут иметь в своем составе несколько одинаковых копий одной и той же информации, будут характеризоваться высокими коэффициентами дедупликации. В то же время для оперативных систем хранения информации, которые владеют фактически уникальным набором данных, показатель дедупликации будет минимален. Если на продуктивном массиве хранится несколько копий оперативной информацией, то это может приводить к увеличению коэффициента дедупликации, так как будут задействоваться механизмы сокращения места хранения данных.

Поэтому иметь для массива оперативных данных показатель дедупликации 5:1 также хорошо, как и владеть коэффициентом 40:1 или 30:1 для систем резервного копирования.

Если для примера взять продукцию компании HPE – массив HPE 3PAR, то для оперативного хранения данных поиск схожих последовательностей обеспечивается на лету с помощью специальной микросхемы ASIC, которая установлена в каждом из контроллеров массива. Благодаря этому существенно разгружаются центральные процессоры массива с той целью, чтобы задействовать их потенциал для более важных задач. Кроме этого, портфель HP для своих массивов предлагает и аппаратные комплексы резервного архивирования данных с поддержкой онлайн дедупликации на уровнях блоков переменной длины. Благодаря этому упрощается и ускоряет процесс переноса информации продуктивных массивов на систему резервного копирования без применения специального софта резервного копирования и без выделения сервера для бэкапов.

Все данные являются одинаковыми

Тут не должно оставаться никаких сомнений – все данные являются разными. Даже те данные, которые получены одного и того же приложения для различных условий будут отличаться коэффициентами дедупликации в условиях одного и того же массива. Это связано с тем, что показатель дедупликации для конкретных данных будет зависеть от различных факторов, среди которых следующие:

- тип данных – данные, которые прошли программное сжатие, метаданные, видеопотоки и зашифрованная информация всегда отличаются небольшим коэффициентом дедупликации или вовсе не поддаются сжатию;

- степень возможной изменяемости данных – чем будет выше объем ежедневных изменений информации на файловом или блочном уровне, тем меньше будет коэффициент дедупликации. Особенно это актуально для систем резервного копирования данных;

- срок хранения – чем больше идентичных копий имеется в хранилище, тем больше будет коэффициент дедупликации таких данных;

- политика резервного копирования – если создавать дневные полные копии вместо использования инкрементных или дифференциальных бэкапов, то можно получить существенно высший коэффициент дедупликации.

Проведение группировки несвязанных типов данных обеспечивает рост уровня дедупликации

В теории можно смешивать разные типы информации в одном пуле для дедупликации. Возникает ложное ощущение, что имея огромный набор данных, будет большая вероятность нахождения в нем уже записанных ранее информационных блоков. На практике все обстоит по-другому. Дело в том, что не связанные типы данных, например между базой данных и Exchange, владеют разными форматами. Даже если они и имеют один и тот же набор информации, то будут казаться разными. В таком случае пул постоянно будет нарастать, усложняться и требовать больше времени для поиска дублирующейся последовательности данных. Лучшей практикой для проведения дедупликации в таком случае является разделения пулов по типу данных.

Для примера, если проводить процедуру дедупликации для одной виртуальной машины, то можно получить некоторый показатель дедупликации. Если же создать несколько копий такой виртуальной машины и после этого провести дедупликацию на этом пуле, то коэффициент дедупликации существенно вырастет. Если же несколько виртуальных машин сгруппировать по типу приложений, а потом создать несколько копий таких машин, то коэффициент дедупликации вырастет еще больше.

Первое резервное копирование может показать величину ожидаемого коэффициента дедубликации

Это ошибочное мнение – оно проявляется при сравнении величины коэффициента дедупликации на основном массиве хранение данных и на системе резервного копирования информации. Если хранить только одну копию архивных данных, то можно получить некоторый коэффициент дедупликации, который будет больше единицы. Его значение сможет вырасти в том случае, если будет увеличено число копий такой резервной информации в текущей базе данных. Выполнение одного резервного копирования показывает определенную дедупликацию, которая является очень приблизительной, поскольку большая экономия достигается в последствии посредством сжатия данных. Как только в пуле появится большое число копий одинаковых данных, коэффициент дедупликации существенно вырастет.

Невозможно увеличить уровень дедупликации.

Ложным является мнение, что не существует возможности искусственного наращивания коэффициента дедупликации. Вопрос возникает в другом – для чего это нужно. Если для отображения каких-то особенных маркетинговых показателей, то это одно, а если для создания эффективной системы резервирования, то это совсем другая реальность. Получить синтетический максимальный коэффициент дедупликации достаточно просто – для этой цели следует хранить в массиве как можно больше копий одинаковых данных. Естественно, это увеличит объем хранимой информации, но коэффициент дупликации может в таком случае принимать очень большие значения. Это может эффективно использоваться в маркетинговых целях, но если же говорить об эффективности работы хранилища, то такие искусственно завышенные коэффициенты дедупликации никакой пользы не дают.

Отсутствует возможность прогнозирования величины коэффициента дедупликации

Большинство производителей систем резервного копирования предоставляют своим клиентам специальные утилиты для работы с массивами и системами резервного хранения информации. Благодаря этим инструментом появляется возможность получения информации о типе данных, политике резервного копирования, а также сроках хранения информации. С помощью таких утилит можно получить определенные данные о величине ожидаемого коэффициента дедубликации. Но максимально точный прогноз по значению показателя дедупликации получается при проведении испытаний с использованием реальных данных и конкретных массивов.

Заключение

Таким образом, процедура дупликации является достаточно простой технологией оптимизации работы хранилища, если правильно разобраться во всех ее нюансах. Следует также отметить, что кроме процесса дедупликации рассматриваются и иные способы эффективного хранения данных. Одним из таких альтернативных решений является устранение копий одинаковых данных – считается, что эта процедура является более эффективной, чем наращивание коэффициента дедупликации и компрессии данных. Правда такой подход нуждается в кардинальном внедрении нового комплекса технических решений и изменения правил работы приложений с архивируемой информацией.